Depois de passar um dia lendo a Lei de Serviços Digitais da UE — uma tarefa que ele não desejaria nem para seu pior inimigo — Murray conclui que não é por isso que o CEO do Telegram está sendo detido.

Pavel Durov, CEO e cofundador do Telegram, em 2015. (TechCrunch, Flickr, CC BY 2.0)

Por Craig Murray

CraigMurray.org.uk

A detenção de Pavel Durov está a ser retratada como resultado da Lei de Serviços Digitais da UE. Mas tendo passado o dia lendo a Lei de Serviços da UE (uma tarefa que não desejaria nem para o meu pior inimigo), ela não me parece dizer o que está sendo retratado como dizendo.

A detenção de Pavel Durov está a ser retratada como resultado da Lei de Serviços Digitais da UE. Mas tendo passado o dia lendo a Lei de Serviços da UE (uma tarefa que não desejaria nem para o meu pior inimigo), ela não me parece dizer o que está sendo retratado como dizendo.

Os Atos da UE são terrivelmente densos e complexos, e são publicados como “Regulamentos” e “Artigos”. Ambos cobrem precisamente o mesmo terreno, mas para fins de execução os “Regulamentos” mais detalhados são os mais importantes, e esses são mencionados abaixo. Os “Artigos” são inteiramente consistentes com isso.

[Durov era formalmente cobrado na quarta-feira e impedido de deixar a França.]

Assim, por exemplo, o Regulamento 20 torna o “serviço intermediário”, neste caso o Telegram, responsável apenas por atividades ilegais usando seu serviço se tiver colaborado deliberadamente na atividade ilegal.

Fornecer criptografia ou anonimato especificamente não se qualifica como colaboração deliberada em atividade ilegal.

"(20) Sempre que um prestador de serviços intermediários colaborar deliberadamente com um destinatário dos serviços para realizar atividades ilegais, os serviços não deverão ser considerados como tendo sido prestados de forma neutra e, por conseguinte, o prestador não deverá poder beneficiar das isenções de responsabilidade previstas no presente regulamento.

Este deveria ser o caso, por exemplo, quando o provedor oferece seu serviço com o propósito principal de facilitar atividades ilegais, por exemplo, tornando explícito que seu propósito é facilitar atividades ilegais ou que seus serviços são adequados para esse propósito. O fato por si só de um serviço oferecer transmissões criptografadas ou qualquer outro sistema que torne a identificação do usuário impossível não deve, por si só, qualificar-se como facilitação de atividades ilegais.”

E no parágrafo 30, não há especificamente nenhuma obrigação geral de monitoramento sobre o provedor de serviços para policiar o conteúdo. Na verdade, é muito forte que o Telegram não tem obrigação de tomar medidas proativas.

"(30) Os prestadores de serviços intermediários não devem estar, nem de jure, nem de facto, sujeitos a uma obrigação de monitorização no que diz respeito a obrigações de natureza geral. Isto não diz respeito a obrigações de monitorização num caso específico e, em particular, não afeta ordens de autoridades nacionais em conformidade com a legislação nacional, em conformidade com o direito da União, tal como interpretado pelo Tribunal de Justiça da União Europeia, e em conformidade com as condições estabelecidas no presente regulamento.

Nada no presente regulamento deverá ser interpretado como uma imposição de uma obrigação geral de monitorização ou de uma obrigação geral de averiguação activa de factos, ou como uma obrigação geral para os prestadores de serviços tomarem medidas proactivas em relação a conteúdos ilegais.. "

O aplicativo Telegram na tela de um smartphone. (Foto Focal, Flickr, CC BY-NC 2.0)

No entanto, o Telegram é obrigado a agir contra contas específicas em relação a uma ordem individual de uma autoridade nacional referente a conteúdo específico. Então, embora não tenha nenhuma obrigação geral de rastreamento ou censura, ele tem que agir por instigação de autoridades nacionais sobre conteúdo individual.

"(31) Dependendo do sistema jurídico de cada Estado-Membro e do domínio do direito em questão, as autoridades judiciais ou administrativas nacionais, incluindo as autoridades responsáveis pela aplicação da lei, podem ordenar aos prestadores de serviços intermediários que atuem contra um ou mais itens específicos de conteúdo ilegal ou que forneçam determinadas informações específicas. As leis nacionais com base nas quais tais ordens são emitidas diferem consideravelmente e as ordens são cada vez mais abordadas em situações transfronteiriças.

Para garantir que essas ordens possam ser cumpridas de forma eficaz e eficiente, em especial num contexto transfronteiriço, para que as autoridades públicas em causa possam desempenhar as suas funções e os prestadores não fiquem sujeitos a quaisquer encargos desproporcionais, sem afetar indevidamente os direitos e interesses legítimos de terceiros, é necessário estabelecer determinadas condições que essas ordens devem cumprir e determinados requisitos complementares relativos ao processamento dessas ordens.

Consequentemente, o presente regulamento deverá harmonizar apenas certas condições mínimas específicas que tais ordens deverão cumprir para dar origem à obrigação dos prestadores de serviços intermediários de informar as autoridades relevantes sobre o efeito dado a essas ordens. Por conseguinte, o presente regulamento não fornece a base jurídica para a emissão de tais ordens, nem regula o seu âmbito territorial ou a sua execução transfronteiriça.. "

As autoridades nacionais podem exigir que o conteúdo seja removido, mas apenas para “itens específicos”:

"51) Tendo em conta a necessidade de ter devidamente em conta os direitos fundamentais garantidos pela Carta de todas as partes interessadas, qualquer ação tomada por um fornecedor de serviços de alojamento após receber uma notificação deve ser estritamente direcionada, no sentido de que deve servir para remover ou desativar o acesso a itens específicos de informação considerados como constituindo conteúdo ilegal, sem afetar indevidamente a liberdade de expressão e de informação dos destinatários do serviço.

Os avisos devem, portanto, como regra geral, ser direcionados aos provedores de serviços de hospedagem que podem razoavelmente esperar ter a capacidade técnica e operacional para agir contra tais itens específicos. Os provedores de serviços de hospedagem que recebem um aviso para o qual não podem, por razões técnicas ou operacionais, remover o item específico de informação devem informar a pessoa ou entidade que enviou o aviso. "

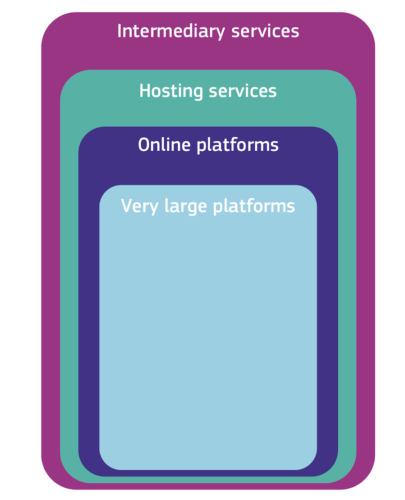

Há obrigações extras para Very Large Online Platforms, que têm mais de 45 milhões de usuários na UE. Essas não são obrigações extras de monitoramento de conteúdo, mas sim obrigações extras para garantir salvaguardas no design de seus sistemas:

As regras da Lei de Serviços Digitais variam para diferentes entidades online para corresponder à sua função, tamanho e impacto no sistema online. (Comissão Europeia, Wikimedia Commons, CC BY 4.0)

"(79) Plataformas online muito grandes e motores de busca online muito grandes podem ser usados de uma forma que influencia fortemente a segurança online, a formação da opinião pública e do discurso, bem como o comércio online. A forma como concebem os seus serviços é geralmente optimizada para beneficiar os seus modelos de negócio frequentemente orientados para a publicidade e pode causar preocupações sociais.

Regulamentação e fiscalização eficazes são necessárias para identificar e mitigar efetivamente os riscos e os danos sociais e econômicos que podem surgir.

Ao abrigo do presente regulamento, os fornecedores de plataformas online de grande dimensão e de motores de busca online de grande dimensão deverão, por conseguinte, avaliar os riscos sistémicos decorrentes da conceção, do funcionamento e da utilização dos seus serviços, bem como de potenciais utilizações indevidas pelos destinatários do serviço, e deverão tomar medidas de atenuação adequadas, no respeito dos direitos fundamentais.

Ao determinar a significância de potenciais efeitos e impactos negativos, os provedores devem considerar a gravidade do potencial impacto e a probabilidade de todos esses riscos sistêmicos. Por exemplo, eles podem avaliar se o potencial impacto negativo pode afetar um grande número de pessoas, sua potencial irreversibilidade ou quão difícil é remediar e restaurar a situação prevalecente antes do potencial impacto.

(80) Quatro categorias de riscos sistémicos devem ser avaliadas em profundidade pelos fornecedores de plataformas online muito grandes e de motores de busca online muito grandes. Uma primeira categoria diz respeito aos riscos associados à divulgação de conteúdos ilegais, como a divulgação de material de abuso sexual de crianças ou discurso de ódio ilegal ou outros tipos de utilização indevida dos seus serviços para infrações penais, e à realização de atividades ilegais, como a venda de produtos ou serviços proibidos pela legislação da União ou nacional, incluindo produtos perigosos ou contrafeitos, ou animais comercializados ilegalmente.

Por exemplo, tal disseminação ou atividades podem constituir um risco sistêmico significativo, onde o acesso a conteúdo ilegal pode se espalhar rápida e amplamente por meio de contas com um alcance particularmente amplo ou outros meios de amplificação. Provedores de plataformas on-line muito grandes e de mecanismos de busca on-line muito grandes devem avaliar o risco de disseminação de conteúdo ilegal, independentemente de a informação ser ou não também incompatível com seus termos e condições.

Esta avaliação não prejudica a responsabilidade pessoal do destinatário do serviço de plataformas online de grande dimensão ou dos proprietários de sites indexados por motores de busca online de grande dimensão pela possível ilegalidade da sua atividade ao abrigo da legislação aplicável.”

(LIBER Europa, Flickr, CC BY 2.0)

“(81) Uma segunda categoria diz respeito ao impacto real ou previsível do serviço no exercício dos direitos fundamentais, tal como protegidos pela Carta, incluindo, mas não se limitando à dignidade humana, à liberdade de expressão e de informação, incluindo a liberdade e o pluralismo dos meios de comunicação social, o direito à vida privada, a protecção de dados, o direito à não discriminação, os direitos da criança e a protecção do consumidor.

Tais riscos podem surgir, por exemplo, em relação ao design dos sistemas algorítmicos usados pela plataforma online muito grande ou pelo mecanismo de busca online muito grande ou ao uso indevido de seus serviços por meio do envio de notificações abusivas ou outros métodos para silenciar a fala ou dificultar a concorrência.

Ao avaliar os riscos aos direitos da criança, os provedores de plataformas on-line muito grandes e de mecanismos de busca on-line muito grandes devem considerar, por exemplo, quão fácil é para menores entenderem o design e o funcionamento do serviço, bem como como menores podem ser expostos por meio de seu serviço a conteúdo que pode prejudicar a saúde, o desenvolvimento físico, mental e moral de menores. Tais riscos podem surgir, por exemplo, em relação ao design de interfaces on-line que intencionalmente ou não exploram as fraquezas e a inexperiência de menores ou que podem causar comportamento viciante.

(82) Uma terceira categoria de riscos diz respeito aos efeitos negativos reais ou previsíveis nos processos democráticos, no discurso cívico e nos processos eleitorais, bem como na segurança pública.

(83) Uma quarta categoria de riscos decorre de preocupações semelhantes relacionadas com a concepção, o funcionamento ou a utilização, incluindo através da manipulação, de plataformas em linha de grande dimensão e de motores de busca em linha de grande dimensão, com um efeito negativo real ou previsível na protecção da saúde pública, de menores e consequências negativas graves para o bem-estar físico e mental de uma pessoa, ou na violência baseada no género.

Tais riscos também podem advir de campanhas coordenadas de desinformação relacionadas à saúde pública ou do design de interfaces on-line que podem estimular vícios comportamentais dos destinatários do serviço.

(84) Ao avaliarem esses riscos sistémicos, os fornecedores de plataformas online muito grandes e de motores de busca online muito grandes devem concentrar-se nos sistemas ou outros elementos que podem contribuir para os riscos, incluindo todos os sistemas algorítmicos que podem ser relevantes…”

Isso é muito interessante. Eu argumentaria que, sob os Artigos 81 e 84, por exemplo, o uso flagrante de algoritmos que limitam o alcance e o bloqueio simples pelo Twitter e Facebook, para promover uma narrativa pró-Israel e limitar o conteúdo pró-Palestina, foi claramente uma violação da Diretiva de Serviços Digitais da UE por interferência deliberada com “liberdade de expressão e informação, incluindo liberdade de mídia e pluralismo”.

A legislação é redigida de forma muito clara com a intenção específica de proibir o uso de algoritmos para interferir na liberdade de expressão e no discurso público desta forma..

Mas é claro que é uma grande verdade que a honestidade e a neutralidade dos serviços de acusação são muito mais importantes para o que realmente acontece em qualquer sistema de “justiça” do que as disposições reais da legislação.

Só um tolo ficaria surpreso que a Lei de Serviços Digitais da UE esteja sendo usada à força contra Durov, aparentemente por falta de cooperação com serviços de inteligência ocidentais e por ser um pouco russa, e não esteja sendo usada contra Elon Musk ou Mark Zuckerberg por limitar o alcance do conteúdo pró-palestino.

Também vale a pena notar que o Telegram não é considerado uma plataforma online muito grande pela Comissão Europeia, que até o momento aceitou a alegação do Telegram de que ele tem menos de 45 milhões de usuários na UE, portanto essas obrigações extras não se aplicam.

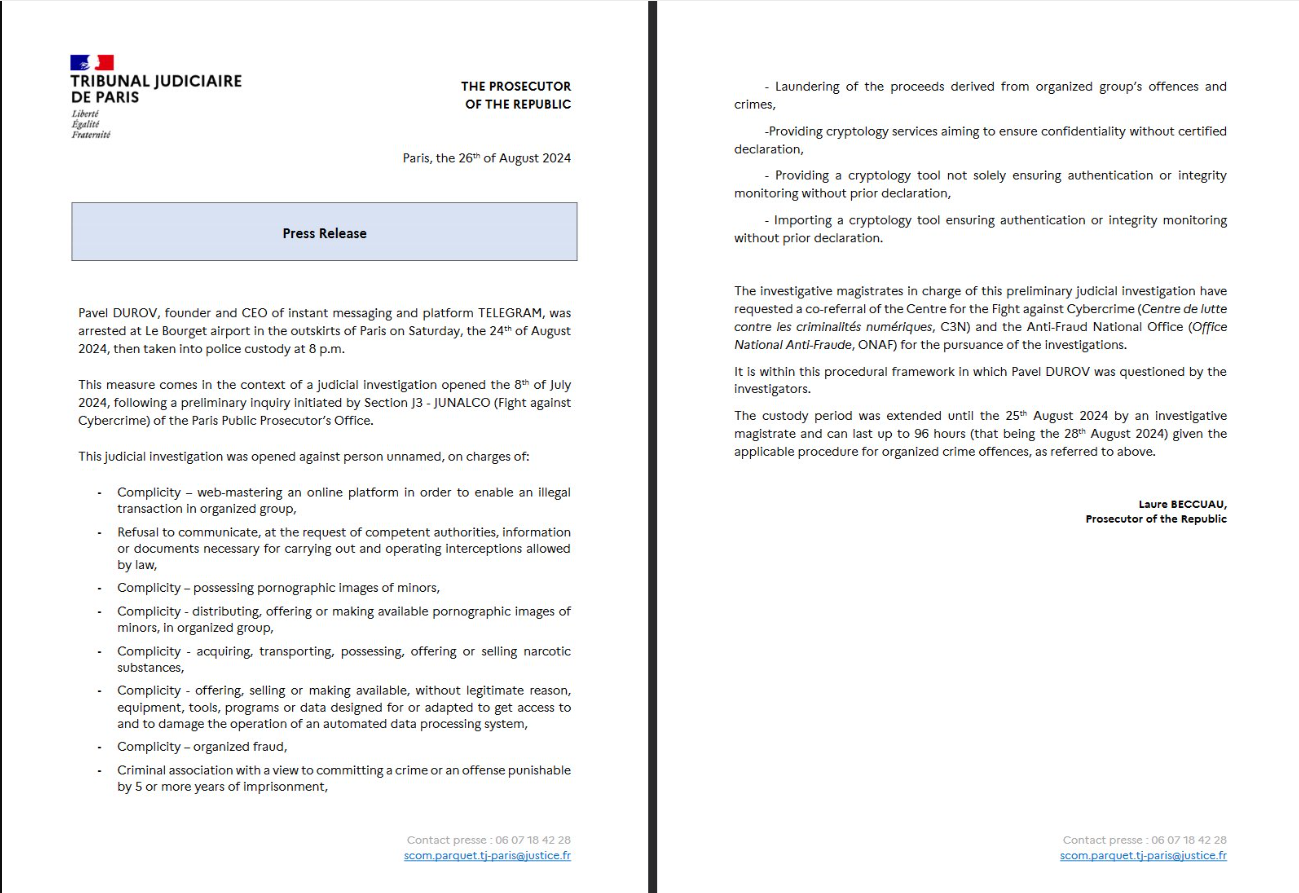

Se analisarmos as acusações contra Durov na França, não consigo ver como elas são de fato compatíveis com a Lei de Serviços Digitais da UE.

A menos que ele tenha se recusado a remover ou agir sobre conteúdo individual específico especificado pelas autoridades francesas, ou a menos que tenha criado o Telegram com a intenção específica de facilitar o crime organizado, não vejo como Durov não esteja protegido pelos Artigos 20 e 30 e outras salvaguardas encontradas na Lei de Serviços Digitais.

As acusações francesas parecem, no entanto, ser extremamente gerais e não se relacionar com comunicações específicas específicas. Isso é um abuso.

O que o Digital Services Act não contém é uma obrigação geral de entregar conteúdo não especificado ou chaves de criptografia para forças policiais ou agências de segurança. Ele também é notavelmente reticente em “desinformação”.

Os regulamentos 82 ou 83 acima obviamente fornecem alguma base para o policiamento da “desinformação”, mas a Lei em geral se baseia na afirmação bastante bem-vinda de que os regulamentos que regem o que é discurso e discurso legal devem ser os mesmos offline e online.

Então, em resumo, a prisão de Pavel Durov parece ser um abuso bem flagrante e apenas muito tênuemente conectado à base legal dada como justificativa. Isso é simplesmente uma parte da atual onda crescente de autoritarismo nas “democracias” ocidentais.

Craig Murray é autor, locutor e ativista dos direitos humanos. Foi embaixador britânico no Uzbequistão de agosto de 2002 a outubro de 2004 e reitor da Universidade de Dundee de 2007 a 2010. Sua cobertura depende inteiramente do apoio do leitor. As assinaturas para manter este blog funcionando são recebido com gratidão.

Este artigo é de CraigMurray.org.uk.

As opiniões expressas são exclusivamente do autor e podem ou não refletir as de Notícias do Consórcio.